在當(dāng)今人工智能技術(shù)飛速發(fā)展的浪潮中,強(qiáng)化學(xué)習(xí)(Reinforcement Learning, RL)作為機(jī)器學(xué)習(xí)的一個重要分支,正日益成為理論與算法軟件開發(fā)的前沿陣地。它不僅模擬了生物體通過試錯與環(huán)境交互進(jìn)行學(xué)習(xí)的基本模式,更在游戲博弈、機(jī)器人控制、自動駕駛、智能推薦等諸多領(lǐng)域展現(xiàn)出巨大潛力。本文將系統(tǒng)性地探討強(qiáng)化學(xué)習(xí)的核心理論與關(guān)鍵算法,并闡述其在軟件開發(fā)實踐中的重要性。

強(qiáng)化學(xué)習(xí)的核心理論框架

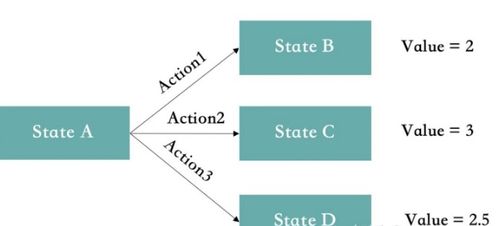

強(qiáng)化學(xué)習(xí)的理論基礎(chǔ)建立在馬爾可夫決策過程(Markov Decision Process, MDP)之上。MDP為描述順序決策問題提供了一個嚴(yán)謹(jǐn)?shù)臄?shù)學(xué)模型,它由五個關(guān)鍵要素構(gòu)成:狀態(tài)集(S)、動作集(A)、狀態(tài)轉(zhuǎn)移概率(P)、獎勵函數(shù)(R)和折扣因子(γ)。智能體(Agent)的目標(biāo),是在這個框架內(nèi),通過與環(huán)境的持續(xù)交互,學(xué)習(xí)到一個最優(yōu)的策略(Policy),即從狀態(tài)到動作的映射規(guī)則,以期最大化長期累積獎勵的期望值。

這一理論框架引出了兩個核心概念:價值函數(shù)和策略優(yōu)化。價值函數(shù)用于評估在特定狀態(tài)下(或采取特定動作后)的長期價值,分為狀態(tài)價值函數(shù)和動作價值函數(shù)。貝爾曼方程則構(gòu)成了價值迭代和策略優(yōu)化的數(shù)學(xué)基礎(chǔ),揭示了當(dāng)前價值與未來價值之間的遞歸關(guān)系。

經(jīng)典算法演進(jìn):從動態(tài)規(guī)劃到深度強(qiáng)化學(xué)習(xí)

強(qiáng)化學(xué)習(xí)的算法發(fā)展路徑,清晰地體現(xiàn)了從理論模型到工程實踐的演進(jìn)。

- 基于動態(tài)規(guī)劃的經(jīng)典方法:在模型已知(即P和R已知)的情況下,策略迭代和價值迭代等算法可以精確求解最優(yōu)策略。它們是理解強(qiáng)化學(xué)習(xí)原理的基石,但在模型未知或狀態(tài)空間巨大的實際問題中直接應(yīng)用受限。

- 蒙特卡洛方法與時序差分學(xué)習(xí):為了在模型未知的環(huán)境下學(xué)習(xí),蒙特卡洛方法通過完整的經(jīng)驗軌跡來估計價值函數(shù),而時序差分(TD)學(xué)習(xí),特別是著名的Q-learning和Sarsa算法,則通過“自舉”的方式,利用當(dāng)前估計值更新下一時刻的估計值,實現(xiàn)了更高效的單步在線學(xué)習(xí)。Q-learning(一種離策略算法)因其簡單有效,成為早期應(yīng)用中最流行的算法之一。

- 函數(shù)逼近與深度強(qiáng)化學(xué)習(xí)的革命:當(dāng)面對高維、連續(xù)的狀態(tài)或動作空間時,傳統(tǒng)的表格型方法遭遇存儲和泛化瓶頸。引入函數(shù)逼近器(如線性模型、神經(jīng)網(wǎng)絡(luò))來擬合價值函數(shù)或策略,是必然選擇。深度強(qiáng)化學(xué)習(xí)(Deep RL)將深度神經(jīng)網(wǎng)絡(luò)與強(qiáng)化學(xué)習(xí)相結(jié)合,取得了里程碑式的突破。

- 深度Q網(wǎng)絡(luò)(DQN):通過經(jīng)驗回放和目標(biāo)網(wǎng)絡(luò)兩大核心技術(shù),穩(wěn)定了深度網(wǎng)絡(luò)在Q-learning中的應(yīng)用,在Atari游戲上達(dá)到甚至超越了人類水平。

- 策略梯度方法:直接參數(shù)化并優(yōu)化策略。REINFORCE算法是其早期代表,而后續(xù)的Actor-Critic框架將價值函數(shù)(Critic)與策略(Actor)結(jié)合,降低了方差,提升了學(xué)習(xí)效率,如A2C、A3C、TRPO和PPO等算法,已成為當(dāng)前復(fù)雜連續(xù)控制任務(wù)的主流選擇。

算法軟件開發(fā):挑戰(zhàn)與工程實踐

將強(qiáng)化學(xué)習(xí)理論轉(zhuǎn)化為穩(wěn)定、高效的軟件系統(tǒng),面臨著獨特挑戰(zhàn),也驅(qū)動著算法開發(fā)工具的進(jìn)步。

- 算法實現(xiàn)復(fù)雜性:RL算法涉及采樣、訓(xùn)練、評估等多個循環(huán),且對超參數(shù)(如學(xué)習(xí)率、折扣因子、探索率)極為敏感。代碼實現(xiàn)需要高度的模塊化和清晰的抽象。

- 環(huán)境交互與仿真:一個標(biāo)準(zhǔn)化、高效的環(huán)境接口是開發(fā)的基礎(chǔ)。OpenAI Gym、DeepMind Control Suite等平臺提供了豐富的基準(zhǔn)測試環(huán)境,極大地促進(jìn)了算法研發(fā)與比較。

- 樣本效率與訓(xùn)練穩(wěn)定性:RL通常需要海量的交互數(shù)據(jù),且訓(xùn)練過程可能不穩(wěn)定。工程上需要集成經(jīng)驗回放、分布式采樣、課程學(xué)習(xí)、以及細(xì)致的監(jiān)控與調(diào)試工具(如TensorBoard、WandB)來應(yīng)對這些挑戰(zhàn)。

- 從仿真到現(xiàn)實(Sim2Real)的鴻溝:在仿真中訓(xùn)練的策略遷移到物理世界時,常因模型不精確而失效。領(lǐng)域隨機(jī)化、系統(tǒng)辨識等算法與工程技術(shù)的結(jié)合,是解決此問題的關(guān)鍵。

未來展望

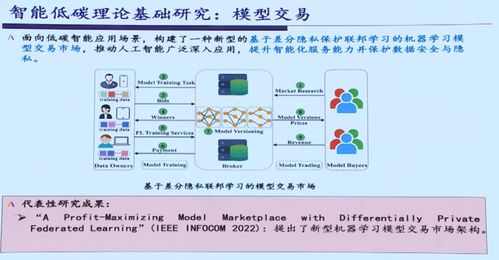

強(qiáng)化學(xué)習(xí)的理論和算法仍在快速發(fā)展中。研究方向包括但不限于:提升樣本效率與泛化能力的元學(xué)習(xí)、探索與利用的更好平衡、多智能體強(qiáng)化學(xué)習(xí)的協(xié)同與競爭、以及將世界模型與規(guī)劃更深度地融合的模型基強(qiáng)化學(xué)習(xí)。對軟件開發(fā)而言,構(gòu)建更強(qiáng)大、易用的開源框架(如Stable-Baselines3, Ray RLlib),降低研究與工程應(yīng)用的門檻,將是推動整個領(lǐng)域進(jìn)步的重要力量。

總而言之,強(qiáng)化學(xué)習(xí)是一門連接人工智能理論、算法創(chuàng)新與復(fù)雜系統(tǒng)軟件開發(fā)的橋梁學(xué)科。掌握其從MDP理論基礎(chǔ)到深度RL算法,再到工程化實現(xiàn)的完整知識體系,對于開發(fā)下一代具有自主決策能力的智能系統(tǒng)至關(guān)重要。